W sieci roi się od ekspertów i znawców, którzy raczą nas swoimi opiniami, choć nie raczyli nawet sprawdzić podstawowych informacji. Tak jest w każdej dziedzinie, w Polsce i w lepszym oraz gorszym świecie. Bardzo mocno dało się to odczuć, gdy Apple zaanonsował nowe sposoby ochrony dzieci i walki z pornografią dziecięcą. Każdy starał się być ekspertem, a 90% „znawców” nie miało pojęcia, jak ma to działać i – co gorsza – takiego pojęcia nie chciało zdobyć. Chcieli tylko uraczyć nas swoimi fobiami i obawami.

Czy dzieci trzeba chronić?

Ile razy zrobiliście coś głupiego, dzieckiem będąc? Żałujecie czasem, że nie miał kto zwrócić Wam uwagi lub złapać za rękę? Jestem pewny, że każdy z Was ma takie wspomnienia z dzieciństwa, których wolałby nie mieć, a sam się do nich przyczynił. Obecnie dzieci mają niestety jeszcze więcej możliwości „zrobienia sobie krzywdy”. Mogą np. zbyt ochoczo zareagować na prośbę „Pokaż …”. I właśnie za ten problem wzięło się teraz Apple.

„Apple sprawdzi nasze wiadomości”

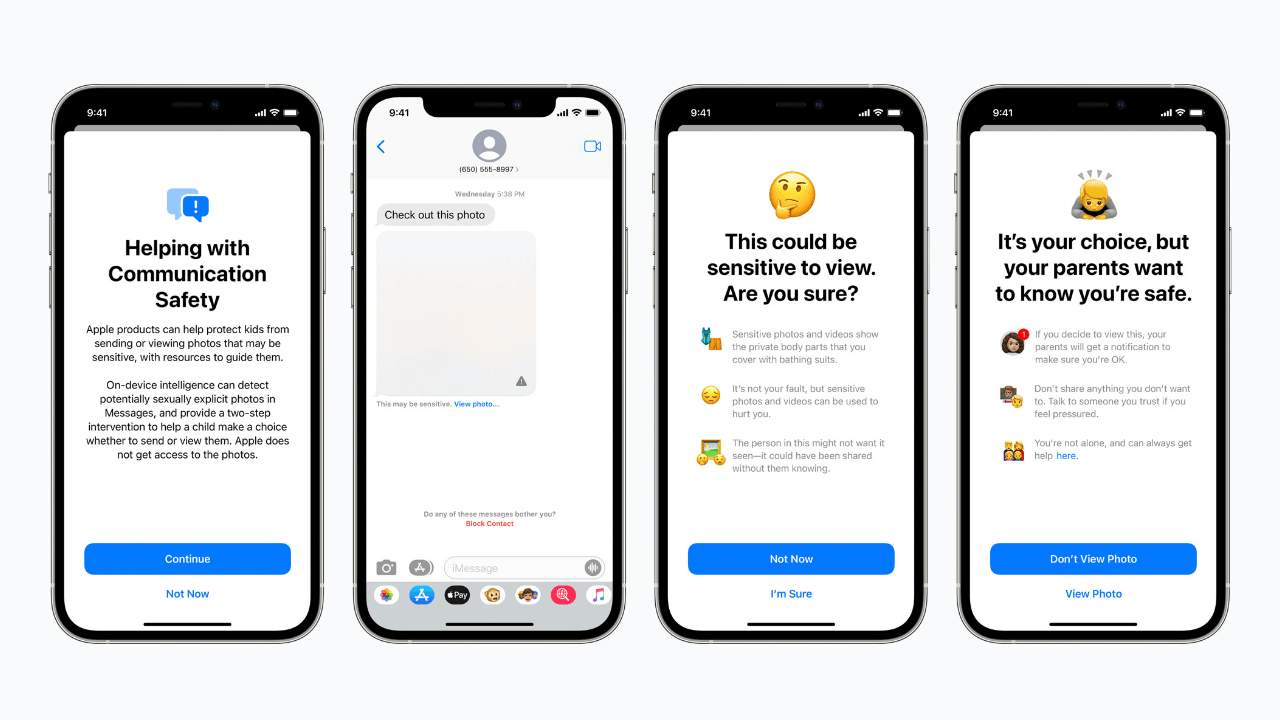

Nie, nie sprawdzi, nie przeczyta, nie obejrzy zdjęć wysyłanych za pomocą iMessages. Więc jak chce sprawdzać, czy dzieci mające konta iCloud dla nastolatków nie otrzymują lub wysyłają nagich zdjęć? Tak samo jak, bez udziału serwerów, wysyłania fotografii, a nawet dostępu do internetu potrafi w zdjęciach zapisanych w iPhone znaleźć osoby, przedmioty i określić sytuacje. Wpiszcie w „szukaj” w Zdjęciach np. „stanik”, „kąpiel” lub „rower”. Zdjęcia wyświetlą fotografie bardzo zbieżne z wyszukiwanym tekstem, bo iPhone sam bez kontaktu z internetem potrafi za pomocą funkcji nauczania maszynowego i AI skojarzyć treść fotografii.

Dokładnie tak samo ma działać funkcja wykrywania nagich zdjęć w wysyłanych i otrzymywanych wiadomościach w iPhone’ach z „dziecięcymi” kontami iCloud. Odpowiedni iPhone (podejrzewam, że z procesorem A12 lub lepszym) w czasie rzeczywistym przeanalizuje zdjęcie i jeżeli dopasuje „wzorce nagości”, to zasłoni je i wyświetli stosowne ostrzeżenie. Jeżeli opiekunowie dziecka włączą odpowiednią funkcję w ustawieniach chmury rodzinnej, to dostaną powiadomienie, że dziecko jednak zdecydowało się wysłać lub obejrzeć nagie zdjęcie. O tym „donosie” dziecko też będzie uprzedzone. To wszystko wewnątrz iPhone’a bez wysyłania czegokolwiek do analizy na jakichkolwiek serwerach. Jasne?

Szkoda tylko, że taka ochrona będzie działać jedynie we Wiadomościach Apple. Dużo większe ryzyko czai się w innych komunikatorach i systemach, których producenci za nic mają dobro dzieci. Szkoda również, że nie ochroni dorosłych przez niechcianymi zdjęciami „penisów”, bo będzie działać tylko na kontach dziecięcych.

Wykrywanie pornografii dziecięcej w zdjęciach wysyłanych doi iCloud

Uwaga: ta funkcja jest całkiem niezależna od wyżej opisanej ochrony dzieci przed nagością we wiadomościach.

To jest już bardziej drażliwa kwestia. Jednak domniemania, jakoby „Apple grzebał nam w zdjęciach” są mocno na wyrost. Zacznę od tego, że o ile sam iPhone (iPad itp.) jest „naszą twierdzą”, to dane wysyłane poza niego już nie i Apple wyraźnie o tym pisze między innymi tu: Omówienie kwestii bezpieczeństwa w usłudze iCloud.

Zdjęcia (i niektóre inne dane z iCloud, ale nie wszystkie) mogą być na żądanie uprawnionych instytucji posiadających odpowiednie nakazy np. sądowe odszyfrowane. Jest to możliwe, bo są kodowane kluczem, który jest przechowywany na serwerach Apple, a nie wyłącznie w naszych urządzeniach. W przypadku nowych funkcji wykrywających pornografię dziecięcą zmieni się to, że jeżeli dobrze opisany w dostępnych opracowaniach algorytm dopasuje wzorzec zakazanego zdjęcia z bazy CSAM, to doda stosowną sygnaturę do niego TYLKO, gdy będzie wysyłane do iCloud. Gdy konto nazbiera zbyt wiele ostrzeżeń, to oznaczone jako podejrzane zdjęcia, mogą zostać zweryfikowane przez ludzi. I to jest rzeczywiście coś, co może budzić pewne kontrowersje. Zaznaczam, że w tym przypadku nie są stosowane ogólne algorytmy rozpoznawania zdjęć, a specjalne stworzone tak, aby pomyłek było mniej niż jedna na bilion (nasz, nie ten amerykański).

Na razie funkcja oznaczania podejrzanych zdjęć wysyłanych do iCloud będzie działać tylko w USA. To może się w przyszłości zmienić, jeżeli Apple znajdzie odpowiednich partnerów.

Jak żyć, gdy Apple nie chce pornografii dziecięcej w iCloud?

Są przynajmniej dwa proste sposoby. Zrezygnować z gromadzenia takich zdjęć lub zrezygnować z iCloud. Dla tych, którzy, choć nie można im nic zarzucić, czują się źle z faktem, że jednak ktoś raz na kilka bilionów może im zajrzeć w zdjęcie, pozostaje zrezygnować z iCloud. Można np. używać zdjęć Google i nie zastanawiać się, czy ktoś lub coś je skanuje, a mniej lub bardziej anonimowe dane pozyskane w ten sposób przekaże do służb, lub sprzeda. Tam mamy pewność, że tak jest.

Nie rozumiesz czegoś? Masz obawy? Najpierw zdobądź wiedzę, później się żal

Nie każdy musi się znać na wszystkim i zresztą nie ma takiej możliwości. Jednak, zanim zaczniemy ferować wyroki, warto zapoznać się, choć z materiałem dowodowym. Jeżeli sam czegoś nie potrafisz zrozumieć, szukaj wiedzy w sprawdzonych źródłach. Pamiętaj też, że nawet autorytetom zdarza się coś chlapnąć. Zanim przyłączysz się do chóru oskarżycieli, poczekaj trochę, niech pojawi się więcej rzetelnych analiz.

Gdzie znaleźć wiedzę na temat funkcji ochrony dzieci w nadchodzących systemach Apple?

Można u samego Apple, ale jest coraz więcej wyważonych i poważnych analiz z innych źródeł np. w Tech Crunch, czy iMore.

Jeżeli będzie taka potrzeba, to mogę streścić wspomniane wyżej artykuły i dokumenty niebawem.

Nie idźcie na łatwiznę, bo zostaniecie Elojami!

Niestety tak to u nas ( w Polsce) jest, nie znam się ale się wypowiem, o ile w komentarzach nie jest to takie drażliwe, chociaż to chyba kwestia przyzwyczajenia, to w przypadku portali technologicznych jest to niedopuszczalne, a tak właśnie wypowiadają się na popularnych portalach, nie znając tematu, nie dowiadując się jak to tak właściwie jest, jak to ma na prawdę działać, po prostu piszą żeby nabić odsłony a, jest to coraz częstsze i jest to smutne.

Prawdę Jaromir napisał i tylko prawdę

Nie wiem co pisze na ten temat internet, i jeśli mam być szczery mało mnie to interesuje, ale dodam swoje 3 grosze. Tak długo jak Apple w urządzeniu rozpoznaje wiadomości czy zdjęcia w różnych celach, jest ok. Natomiast jeśli informacje o nich wysyła na własne serwery jednocześnie identyfikując w tym użytkownika, daje to pole do ogromnych nadużyć. Jakich? To już choć by sprawa słynnego Snowdena jest opisana prostym językiem w jego biografii… mówimy o świecie 10 lat później. Apple może i coś tworzy w dobrej wierze (głównie oczywiście swojej – dla korpo liczy się tylko potencjalny zysk z danej decyzji), ale finał finałem w imię bezpieczeństwa rezygnuje z naszej wolności. A jak to dobrze wiemy kto z niej w taki sposób rezygnuje nie zasłużył ani na bezpieczeństwo ani na wolność. Oby z tego wyszło coś pozytywnego.

Wystarczy zrezygnować z iCloud, które i tak zawsze może zostać rozszyfrowane.

Nie można zrezygnować z iCloud. Ciągłe zalogowanie do iCloud jest wymagane przez iOS do instalowania aplikacji z Apple App Store i innych funkcji telefonu. Można wyłączyć opcję synchronizacji zdjęć z iCloud, ale urządzenia Apple są znane z nieoczekiwanego uaktywniania różnych swoich opcji bez udziału użytkownika, na przykład przy konfiguracji usług powiązanych Apple, lub przy uaktualnianiu systemu iOS. Takie „zabezpieczenie” to żadne zabezpieczenie, a tykająca bomba.

Sami nakręcacie

https://mojmac.pl/2021/08/09/o-watpliwym-bezpieczenstwie-apple/

Sprawdź autora. Właśnie m.in. dlatego napisałem swój art.

Tak, zdaję sobie sprawę z tego, że tekst jest od innego autora:-)

Fajnie, że jestescie róznorodni i w ramach jednego portalu są odmienne punkty widzenia.

Wszystko ok, ale potem „w razie czego”, zdjęcia sprawdza człowiek, a czy aplikacje „kontrolujące” są nieomylne? Niech każdy sam sobie na to pytanie…

Nie są, tak smao jak i człowiek nie jest. Tyle że człowiek może pomylić się częściej. Algorytmy stosowane przez Apple mulą się raz na bilion, a do tego jedno „zgłoszenie” nie wystarczy. Pamiętaj, że obecnie na prawomocne żądanie służb, Apple może odkodować zdjęcia i niektóre inne dane w iCloud. Jeżeli korzystasz z iCloud, to na pewno masz tego świadomość i liczysz się z taką możliwością.

Zgoda może – sprawy prawne- ale obecna propozycja to kompletnie „inny temat”.

Do tego jeszcze sprawa dziur w algorytmach, zła ocena – to tylko Soft- co za tym idzie ingerencja przez człowieka w zdjęcia, ktoś musi sprawdzić… W kwestii „dziur” pewne modyfikacje mogą zmienić działanie algorytmu, po prostu Apple otwiera puszkę nawet już nie pandory a z całą pandorą. Najbardziej bawi mnie porównywanie z Facebookiem albo Google i argumentacja Oni tak robią od dawna! No robią ale nie grzebiąc w „prywatnych” zdjęciach.

Zacytuje przepraszam już nie pamietam kto to powiedział „ ludzie uczciwi nie muszą się bać niczego z wyjątkiem ludzi nieuczciwych”,.

Ten tekst jest kwintesencją działań Apple, pewnie mają dobre zamiary ale… Ktoś to wykorzysta do innych celów , dlatego nie powinno się na to pozwolić, a buntować się możemy My, nie korzystając z iCloud masowo, wtedy Apple nie będzie kombinowało …

Ja to rozumiem ale każdy „ciut ogarnięty” , w kwestiach „bezpieczeństwa danych”, wie czym to śmierdzi dla każdego z nas…

I to nie ma znaczenia czy dziś masz czy nie masz „coś” do ukrycia, za miesiąc możesz już mieć i nie chodzi tylko o sprawy osobiste.

Generalnie niezależnie od naszych „odczuć początkowych”, powinniśmy bić na alarm w tego typu kwestiach, w przypadku walki z terroryzmem i pornografią nadużywane są argumenty w celu dostępu do danych „niejawnych”, wykorzystywanych na różne sposoby, również nielegalnie, przez ludzi „nie uprawnionych”, a sam efekt in plus jest znikomy.

To tak jak afera pegasus, niby miało być kontrolowane, niby tylko przestępcy, a jak było teraz już wiemy…

Zabawne, ale to nie Pandora była plagą, ale zawartość jej puszki, którą pomimo zakazów, z ciekawości otworzyła. Pandora to pewna ciekawska dziewczyna, a nie rzecz. Imiona pisze się wielką literą.

Wyjaśnij mi różnicę pomiędzy stanem przyszłym a obecnym. Apple jest w posiadaniu kluczy deszyfrujących wiele z danych zawartych w iCloud. Napisz mi, co tak dokładnie się zmienia? Przecież teraz też ktoś z Apple może (na żądanie władz lub nie koniecznie) odszyfrować dane. iCloud jest bezpieczny tylko w części szyfrowanej kluczem prywatnym.

Zgadza się – patrz Chiny…

Pan Jaromir, autor artykułu, nazywa innych techno-matołkami, a sam jednocześnie ignoruje fundamentalne problemy z nową technologią Apple CSAM, o których wspomina wielu krytyków pomysłu Apple na świecie: technologia ta może być wykorzystywana przez rządy krajów do monitorowania „grup niepożądanych” – opozycjonistów w Chinach czy Rosji, gejów na Bliskim Wschodzie, itd. Rząd danego kraju nie może nakazać danej firmie stworzenia od zera jakiejś nowej technologii masowego monitorowania populacji, gdyż firma ta zawsze może bronić się twierdząc, iż taka technologia jest niemożliwa do stworzenia, ale kiedy raz już jakaś technologia staje się rzeczywistością, to dany rząd może – całkowicie potajemnie – zażądać od Apple skanowania użytkowników iPhone-ów nie tylko pod kątem CSAM, ale także po kątem innych treści. Kto jak kto, ale my, Polacy, powinniśmy szczególnie dobrze rozumieć tego typu niebezpieczeństwa. Oczywiście Apple twierdzi, że nigdy nie ugnie się przed tego typu totalitarnym żądaniom, ale trzeba zadać sobie pytanie co z ceną akcji firmy Apple na giełdzie w Nowym Jorku zrobiłaby decyzja rządu Chin aby wyrzucić Apple ze swojego rynku, kosztem kilku bilionów dolarów dochodu Apple rocznie. Czy Apple, jako firma, fanatycznie dotrzymuje słowa, nawet kosztem pieniędzy? Trzeba przypomnieć sobie sławetny, monstrualny billboard na 15 pięter, który w 2019 zainstalował Apple w Las Vegas: „co dzieje się na twoim iPhonie, zostaje na twoim iPhonie” czy szumny slogan: „prywatność to podstawowe prawo człowieka” nadal widoczne na stronie „http://www.apple.com/privacy/”. Należy także wspomnieć, że z technologicznego punktu widzenia n-i-c nie przeszkadza Apple ani w skanowaniu całego iPhone (a nie tylko zdjęć wysyłanych do iCloud), ani w wyszukiwaniu zdjęć na tematy odmienne od CSAM. Na drodze do stuhrowskiej „permanentnej inwigilacji” stoją tylko i wyłącznie obietnice Apple, n-i-c innego – ani technologia, ani prawo, ani interes akcjonariuszy. Na koniec pamiętajmy także pierwiastek ludzki: nie ma się co tak strasznie dziwić, że żaden właściciel iPhone’a za tysiąc czy dwa tysiące złotych nie chce czuć się jak potencjalny oślizgły pedofil, którego trzeba monitorować (!) pod kątem posiadania odrażających zdjęć (!) i którego trzeba trzymać na elektronicznej smyczy automatycznego informowania organów ścigania, pod groźbą nieoczekiwanego aresztowania (!). Takie traktowanie swoich klientów telefonów klasy premium to niewytłumaczalnie kosmiczna głupota ze strony Apple. A może to (już) coś innego niż głupota?

Wszyscy cały czas zapominają, że klucze do odszyfrowania sporej części iCloud w tym zdjęć są w rękach Apple, a np. w przypadku Chin w rękach rządu. Dodatkowo informacja o przekroczeniu ilości dopasowanych zdjęć (czyli takich samych jak w bazie pornografii dziecięcej) powyżej 30 (taka granica będzie ustawiona) będzie przekazywana do Apple, a nie rządu. Apple jednocześnie ogłosiło, że podda cały proces niezależnemu monitoringowi (nie „ofiary” dopasowań, a sposób działania systemu).

Technomatołkami nazywam tych, to co pisali, że „Apple sprawdzi nasze wiadomości”. Co do reszty, jak pewnie zauważyłeś sam mam pewne wątpliwości, jednak niezbyt wielkie. Nie zauważyłeś?

Proszę zweryfikować swoje źródła prawne: w momencie kiedy Apple rozszyfrowuje informacje o odpowiedniej liczbie dopasowanych zdjęć CSAM, Apple nie ma wyboru, tylko absolutnie m-u-s-i przekazać tę informację organom ścigania. Jest to wymagane prawnie w USA. Niezależny monitoring nie robi tutaj nikomu żadnej różnicy.

Jeszcze raz: to mało ważne, jak rozwiązanie technologiczne proponowane przez Apple wygląda w danym momencie lub czy Apple ogłosiło niezależny monitoring. Rozwiązanie technologiczne może zostać zmodyfikowane, całkowicie tajnie, w wersji 15.0.1 systemu iOS (skoro EULA została już zaakceptowana przez użytkownika). Współpraca z niezależnym audytorem może zostać zawieszona „z przyczyn proceduralnych” po głosowaniu rady nadzorczej Apple. I tak dalej, ad infinitum. Na stronie http://www.apple.com/child-safety/ widnieje jasne zdanie: „[nasze wysiłki w kwestii monitorowania] będą ewoluować i rozszerzać się z czasem.”

Albo dana technologia istnieje i zostaje wdrożona, albo nie istnieje i nie zostaje wdrożona. Albo konkretne aspekty rozwiązania technologicznego uniemożliwiają Apple współpracę z rządami totalitarnymi, albo Apple może być zmuszone, w całkowitej tajemnicy, do takowej współpracy.

Cenę zapłacą ludzie.

Niestety zgadzam się – my zapłacimy .