Nie wiem, czy zwróciliście na to uwagę. iPhone XR, choć ma tylko jeden tylny aparat, potrafi wykonywać zdjęcia, w których tak samo, jak w Xs można zmieniać głębię ostrości, symulując inną przesłonę. Dodatkowo radzi sobie bardzo dobrze z efektami „studyjnymi” w zdjęciach portretowych. Już podczas konferencji zacząłem się zastanawiać, jak uzyskano efekt głębi bez dwóch aparatów.

Pierwszy trop w iOS 12

Jeszcze przed konferencją, na Twitterze pojawił się wpis Bena Sandofsky’ego przedstawiający różnicę w maskowaniu zdjęcia tworzonego w trybie portretowym pomiędzy iOS 11 i iOS 12. Test wykonano iPhone’em X. Do maski programiści mogą mieć dostęp z poziomu API systemowego. Różnica jest ogromna. To wszystko dzięki samym udoskonaleniom w oprogramowaniu Core ML i lepszym wzorcom do analiz neuronowych.

iOS 11 depth data vs iOS 12 portrait matte. The edge details are crazy. Also, I need a shave. pic.twitter.com/X3gwgNABTl

— Ben Sandofsky (@sandofsky) August 8, 2018

Jenak sama maska nie wystarczy, aby stworzyć tak doskonałe efekty zmiany przesłony (ostrości), jakimi pochwaliło się Apple podczas prezentacji. Do tego potrzeba więcej danych.

I tu na szczęście trafiłem na artykuł Lance Ulanoffa. Nie tylko wyjaśnia, co stoi za tak wspaniałymi zdjęciami, które mogą robić iPhone’y 2018, ale i omawia te efekty z uznanym fotografem Pete Souzą.

Jak działa przesłona

Jeżeli posługiwaliście się aparatami z obiektywem, który można regulować, zauważyliście pewnie, że zmieniając przesłonę (jasność, wielkość otworu, przez które wpada światło), zmienia się głębia ostrości. Im większa przesłona (mniejszy otworek), tym ostrzejsze zdjęcia niezależnie od tego, jak daleko znajdują się obiekty. Po prostu światło wpada przez mały otworek w uporządkowany sposób. Gdy przesłona jest mała, czyli otwór duży, to światło dociera do matrycy z różnych kierunków, powodując chaos. Dlatego za pomocą odpowiedniego ustawienia ostrości soczewkami trzeba skupić się na obiekcie w określonej odległości od aparatu. I to on będzie ostry, a to, co przed i za nim nie. Dlatego w jasny dzień, aby zrobić zdjęcie portretowe, należy ustawić bardzo krótkie czasy naświetlania, aby można było otworzyć szerzej przesłonę (zmniejszyć ją).

Mając nowego iPhone’a nie musimy się tym przejmować podczas robienia portretu. Przesłonę „ustawimy” już po wykonaniu fotografii. Oczywiście będzie to emulowane.

TrueDepth lub dwa obiektywy

Do tej pory, aby emulować efekt portretowy, używane były dwa aparaty lub TrueDepth z FaceID w przedniej. Jednak teraz w zasadzie identyczny efekt będzie uzyskiwany za pomocą jednego obiektywu w iPhone XR. Do tego już po wykonaniu zdjęcia zasymulujemy wartość przesłony, czyli głębię ostrości.

Przykro mi, ale znów będzie o A12 Neural Engine

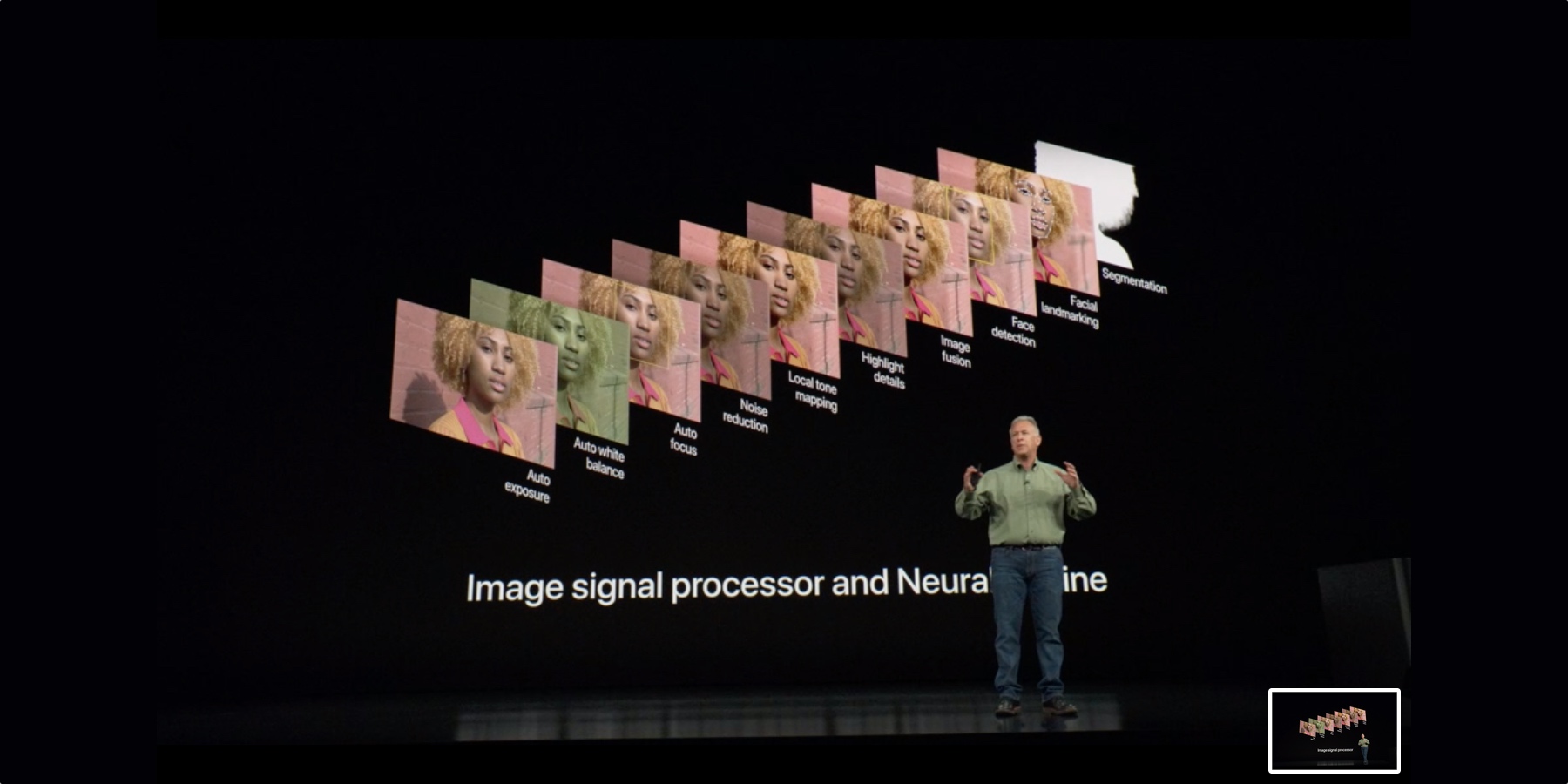

Schiller podczas konferencji opisywał, jak złożony jest system analizy podczas wykonywania zdjęcia. Jest ono badane pod wieloma aspektami jak ruch, blaski, wykrywanie twarzy, odcień skóry, tło ostrość itp. Dodatkowo w trybie portretowym zdjęcie dzielone jest na plany. Dzięki 8-krotnie szybszemu Neural Engine w A12 wystarczą do tego dane z jednego obiektywu.

To nie koniec. Zmienny efekt głębi nie polega na prymitywnym rozmyciu tła, tak jak to robią niektóre zabawki obecnie. W iPhone na fotografię jest nakładany algorytm symulujący pracę prawdziwych soczewek.

Zdjęcia portretowe z efektem zmiany przesłony to tylko jeden, ale bardzo obrazowy sposób wykorzystania nowego podejścia do fotografii cyfrowej, właśnie za pomocą sztucznej inteligencji. Neural Engine jak już wspomniałem, intensywnie jest wykorzystywany również w „zwykłych” fotkach oraz podczas filmowania.

Niebawem pierwsze egzemplarze dotrą do użytkowników, więc dowiemy się, jak ta technologia sprawuje się w rękach typowych amatorów mobilnej fotografii.

Na koniec warto jednak wspomnieć, że robiąc zdjęcia w trybie portretowym, nie mamy wielkiego wpływu na, to co ma być głównym obiektem. Fotografując z ręcznymi nastawami, możemy zdecydować, np. że ostry ba myć element będący gdzieś w tle 3 m od nas, a rozmyte wszystko przed nim. Takie zdjęcia również daje się wykonać nawet starszym iPhone’em, ale bez takiego wsparcia jak w trybie portretowym. Trzeba się trochę nakombinować. Czyli nadal jest wiele do zrobienia w dziedzinie emulacji lustrzanek.

Źródło, które warto przeczytać: medium.com

Marketingowa papka… Szkoda że nie przekłada się to na jakość fotek i efektu w porównaniu do konkurencji. Widać to na przykładowych zdjęciach. Czekam też na profesjonalne testy. iPhone stracił pozycję telefonu robiącego najlepsze zdjęcia. Kupowanie obiektywu od innych firm (które też sprzedają telefony) na pewno tego nie zmieni.

iPhone X tego nie otrzyma a działa to tak samo. Nawet jest aplikacja firmy trzeciej o nazwie Focos która robi efekt głębi. Tej papki nie da się znieść. Dla mnie jako posiadacza właśnie X nieładne zagranie. Rozumiem że nowe paletki sa tak mało odmienne że Apple musi stosować takie tanie różnice aby nowy był lepszy i odmienny. Twój podziw kościoła Apple mnie przeraża, a otoczenie ma mnie za maniaka zgniłego ekosystemu.