Jakiś tydzień temu Sebastian podesłał mi link do dokumentacji jednego z nowych „API”, które Apple udostępniło (udostępni) w nowych wersjach swoich systemów, czyli iOS 10, macOS, watchOS i tvOS. To nowe narzędzie oddane programistom to Basic Neural Network Subroutines, czyli „podstawowe neuronowe podprogramy sieciowe”. Jeżeli macie jakieś skojarzenia ze sztuczną inteligencją to jesteście całkiem blisko.

Nowe narzędzia działają na bazie sieci neuronowych i pozwalają (w uproszczeniu) na rozpoznawanie czy dane wejściowe (np. obrazek) odpowiadają wzorcom powstałym za pomocą „nauczania” sieci neuronowej. Wzorce muszą być dostarczone do API BNNS i sam system nie ma możliwości uczenia, a jedynie używa gotowych danych.

Nawet nie spodziewałem się, że już mogę sprawdzić jak „sieci neuronowe” spisuję się w moim iPhone i MacBooku Air. Odważni też mogą doświadczyć działania Basic Neural Network Subroutines, jeżeli zainstalują w swoich 64-bitowych iPhone betę iOS 10 lub macOS 10.12 na komputerach. Sam trafiłem na efekt działań BNNS przypadkiem.

Bardzo udoskonalona aplikacja zdjęcia.

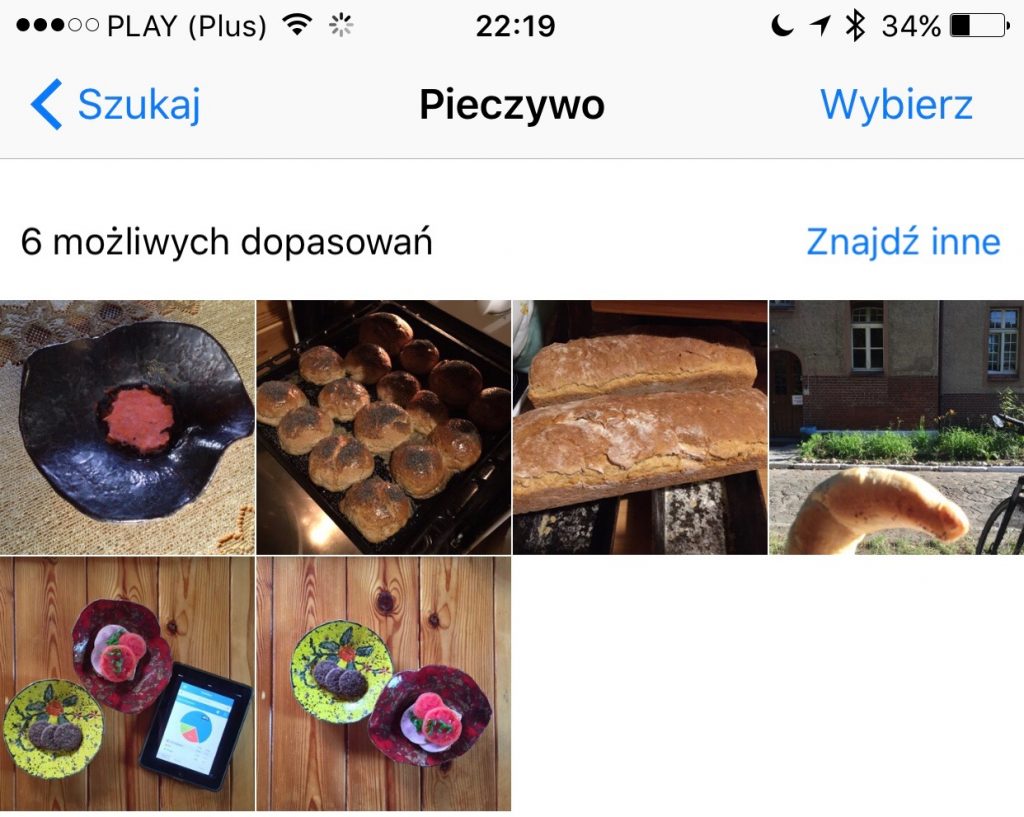

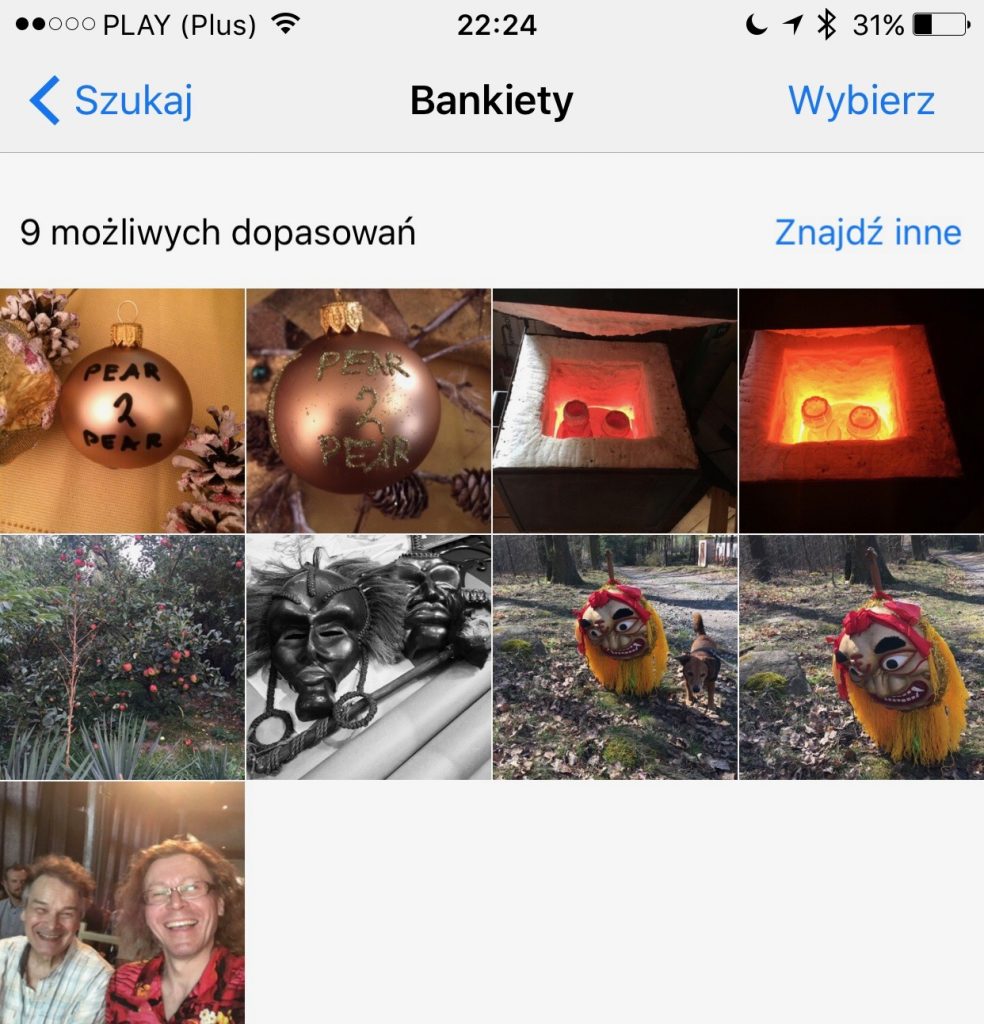

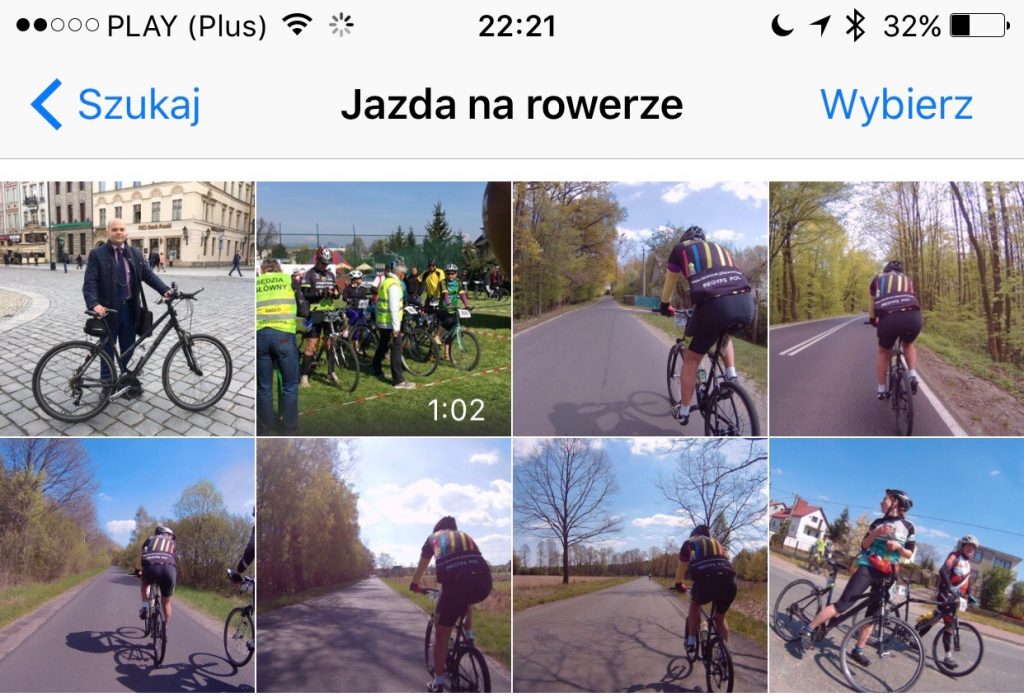

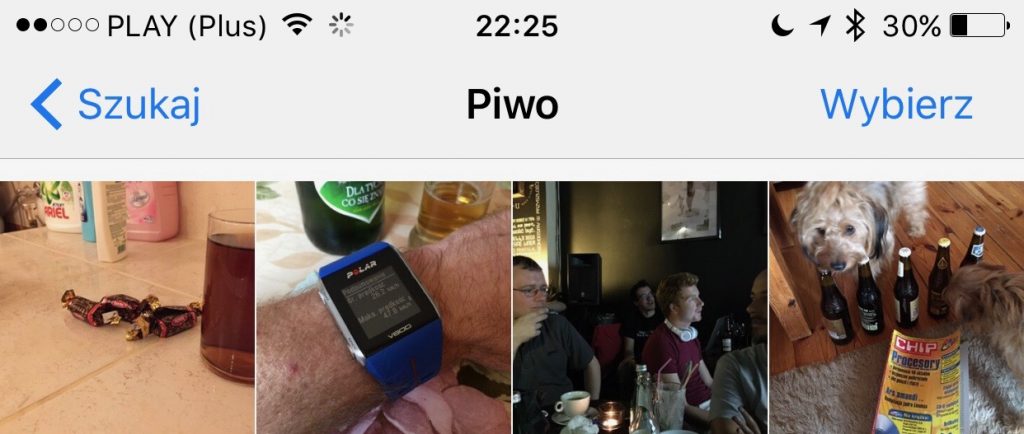

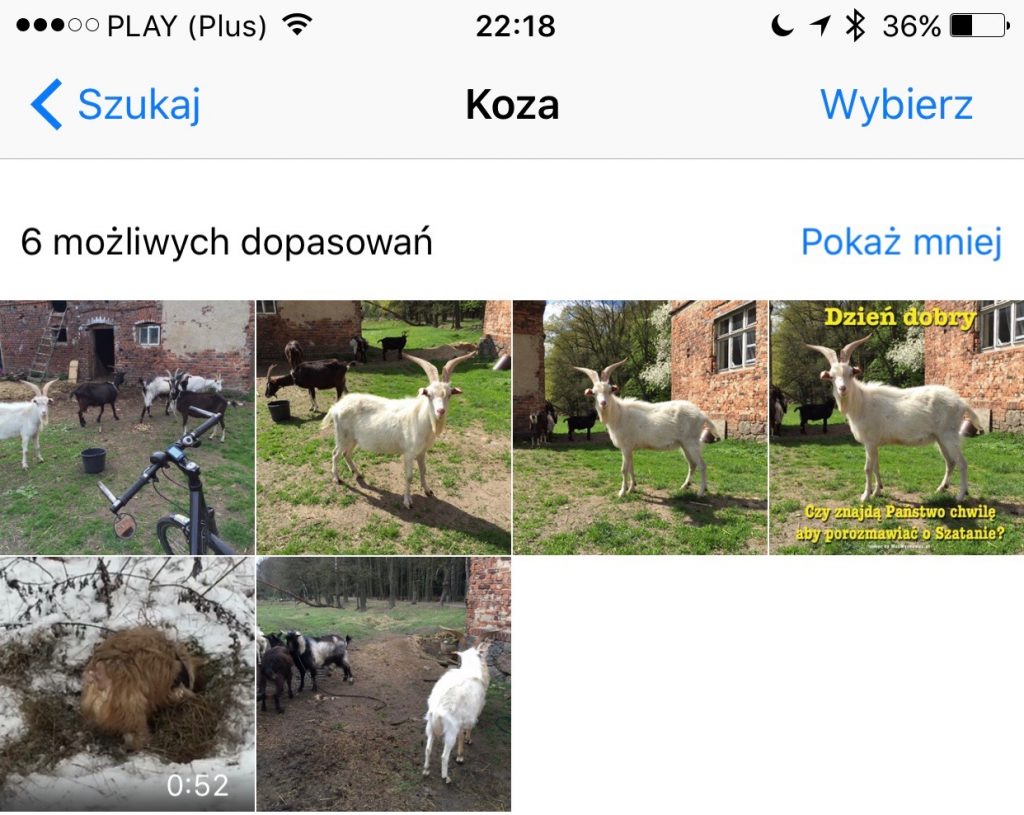

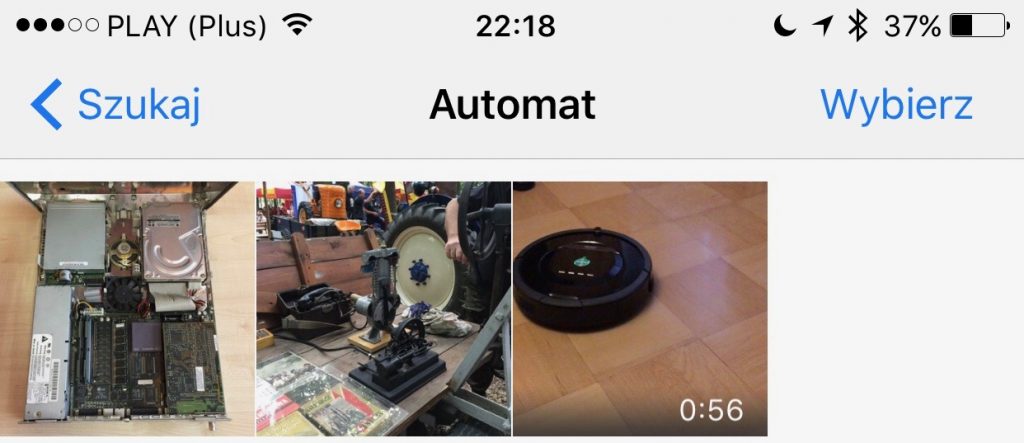

Podczas WWDC 2016 mówiono o funkcjach rozpoznawania scen, przedmiotów i twarzy w nowych wersjach aplikacji Zdjęcia. Jednak nie do końca wiedziałem, że działa to nie tylko do sporządzanie „wspomnień”. Swoistego „odkrycia” dokonałem, gdy potrzebowałem zdjęcia roweru. Z nadzieją, że kiedyś jakieś zdjęcie odpowiednio opisałem, wklepałem w pole wyszukiwania aplikacji Zdjęcia „rower” i moim oczom ukazała się „kategoria rower”, a w niej ponad setka moich zdjęć rowerów. Od razu zacząłem sprawdzać, czy inne hasła też tak zadziałają. Okazało się, że tak! Na hasło „psy”, aplikacja Zdjęcia znalazła fotografie psów, na hasło „koza” znalazła kozy. „Pociągi” – pociągi, „drzewo” – drzewa i lasy, „grzyby” – muchomory i kanie, „koty” – psy (bo moje psy nie są wielkie). Na ogół trafność automatycznego oznaczenia zdjęć jest bardzo duża!

VoiceOver nabiera kolejnych mocy! [aktualizacja]

Uwaga! Jak słusznie zauważył Piotr Witek na Twitterze, dzięki „neuronowej sztucznej inteligencji” funkcja VoiceOver w aplikacji zdjęcia nabrała nowych potężnych mocy. Musicie koniecznie sami wypróbować jak opisuje zdjęcia w iOS 10. Że strony Wsparcie dotyczące dostępności Apple dowiecie się jak włączyć i używać VoiceOver. Naprawdę warto wykonać ten eksperyment, usłyszycie np. „Prawdopodobnie ssak, psowate, pies, owczarek niemiecki. Prawdopodobnie piłka” lub „Dworzec kolejowy, prawdopodobnie pociąg, konstrukcja”, czy „Prawdopodobnie kemping, piwo, jedzenie”!

Ilość kategorii, jakie są rozpoznawane, również jest ogromna. Nawet poszczególne rasy psów mają swoje wzorce „neuronowe”. Sprawdzając po literce, trafiłem na kategorie jak „alkowa”, „buduar”, „pies kongijski”, „kamienie nagrobne”, „owczarek niemiecki” „nagroda”, „las”, „brzeg jeziora”. Mnóstwo tego! Przy niektórych wyszukaniach mamy opcję pokazania większej ilości dopasowań takich mniej „pewnych”.

Nic nie wycieka.

Tak jak rozpoznawanie twarzy, również rozpoznawanie scen i przedmiotów odbywa się w naszych urządzeniach. Nie musimy mieć nawet włączonej iCloud Photo Library czy innej funkcji wysyłającej na serwery nasze zdjęcia i filmy. Właśnie – filmy również są analizowane i bardzo poprawnie kategoryzowane.

Jak możecie zobaczyć, system rozpoznawania obrazów działa bardzo dobrze, choć nie uczy się w naszym urządzeniu, a jedynie korzysta z opracowanych przez Apple (w tym przypadku) wzorców. Widać kawał dobrej roboty zarówno w systemowym oprogramowaniu rozpoznającym, jak i w przygotowaniu wzorców. Bardzo mnie ciekawi jaki użytek z Basic Neural Network Subroutines zrobią deweloperzy w swoich aplikacjach, bo jak widać po zdjęciach możliwości są ogromne.

Zobaczcie jak funkcja rozpoznawania przedmiotów i zdjęć działa w II becie iOS 10:

W Google to działa od lat 😀

Może najpierw niech nauczą Siri po polsku.

Och serio? Pokaż mi urządzenie z androidem, które bez wysłania zdjęć do chmury, samo (bez dostępu do internetu nawet) tak trafnie rozpozna zdjęcia.

Czekam…

Skoro pytasz, to pewnie takiego nie ma. A nie ma, bo nie ma potrzeby.

Zwykle takie wyszukiwanie jest potrzebne wtedy, gdy się szuka nie w swoich zbiorach, tylko w necie. Swoje zbiory taguję, więc jak wpisze koza, to wyskoczy koza. Do tego wynalazek apple nie jest mi potrzebny.

I wie to każdy fotograf 🙂

Inna sprawa, że taką funkcję Apple robi, bo potrzebuje mieć, tak jak własne mapy.

Ale jak powiem „koza” do siri, to w wynikach może znaleść się zupełnie inna koza 😀 wiec może lepiej niech się uczy polskiego 🙂

Należy Ci się karny kutas za czytanie tekstu bez zrozumienia!

1. Chodzi o analizę zdjęć w urządzeniu.

2. Siri nie ma nic do tego (teraz), działa idealnie po polsku.

3. Ilu użytkowników iPhonów taguje powiedzmy z 30% sowich zdjęć chociaż? 5% userów? Jak mogłeś (gdybyś przeczytał uważniej) zrozumieć z tekstu jest to idealne narzędzie dla leniwych. Pięknie znalazło mi to czego szukałem.

4. Nie pomyślałeś o niewidomych i innych z problemami z widzeniem.

Oto kutas dla Ciebie: http://qsap.eu/Kutasy/KARNY_KUTAS_ZA_CZYTANIE_BEZ_ZROZUMIENIA.png

1. analiza zdjęć po tym co jest na zdjęciu, to cały czas to samo co miałem na myśli i co napisałem.

2. Nie miałem przyjemności, ze mną rozmawiać nie chciała

3. Tu się zgodzę 🙂

4. No tu faktycznie, choć niewidomemu to i kadzidło nie pomoże.

Karny kutas nie otwiera 🙂