iPhone X jest już wyposażony w skaner 3D. Jednak ma on ograniczony zasięg i działa tylko od strony ekranu. Tak, to ten emiter kropek z kamerą w podczerwieni używany do Face ID, animoji oraz efektów 3D w czasie rzeczywistym, nakładanych na obraz twarzy.

Apple od lat poszukuje rozwiązań do skanowania 3D

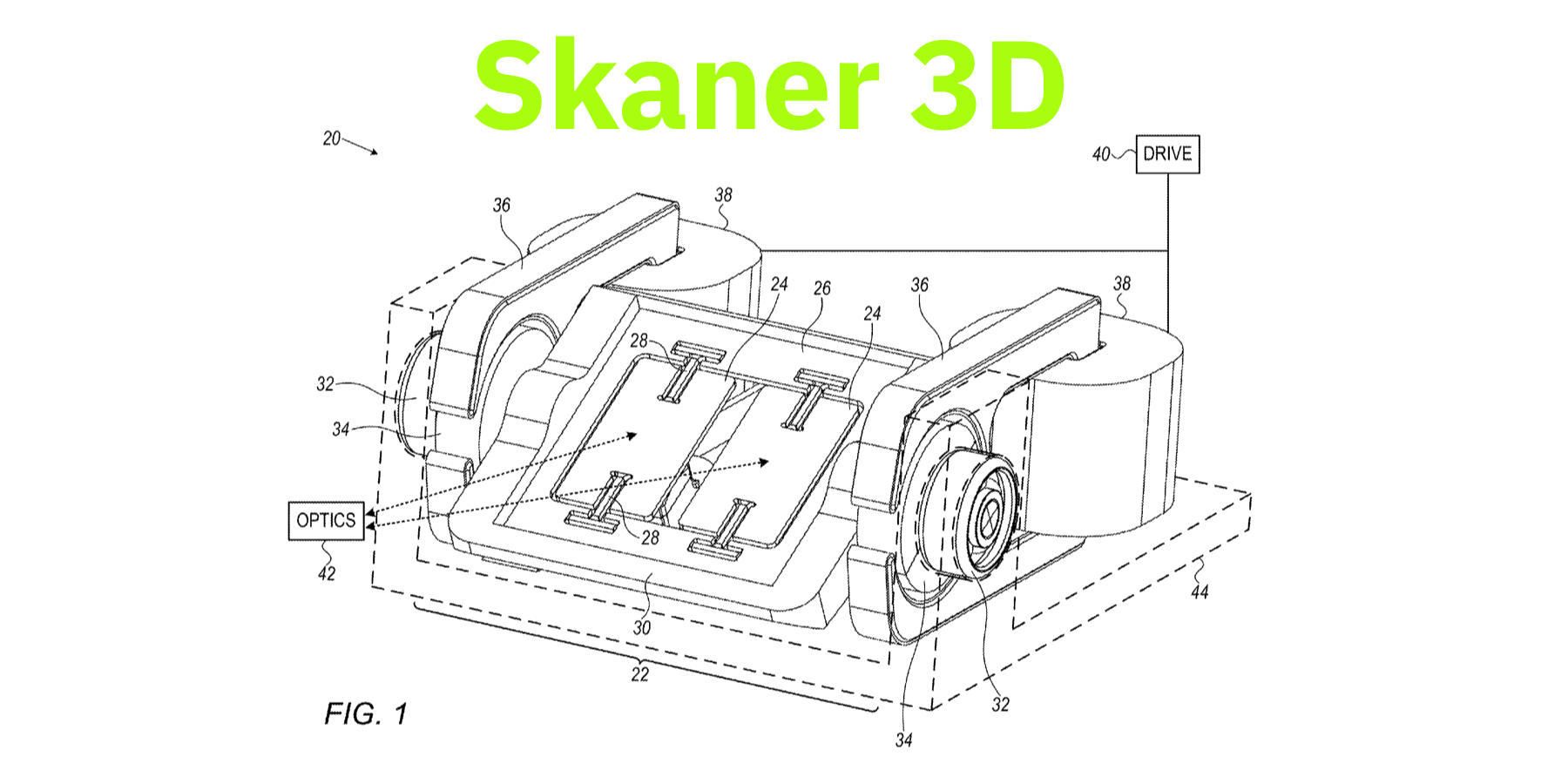

W sierpniu 2016 roku urząd patentowy ogłosił przyznanie firmie Apple praw do patentu, związanego z miniaturowym modułem skanera 3D, złożonego jeszcze w 2015 roku. I nie jest to ani pierwszy, ani jedyny patent Apple związany z tą technologią. Firma w portfolio ma już patenty na użycie 3D do obsługi interfejsu np. w komputerach i smart-okularach za pomocą gestów. Jeden z wielu opisuje Patently Apple. Inne patenty 3D dotyczą m.in. systemów podobnych do użytego w Face ID. Niebawem przyjdzie czas na coś więcej.

Apple i AR

W iOS 11 pojawiło się nowe API. Jest to ARKit. Wraz z nim znacznie zwiększyła się ilość i jakość aplikacji używających rozszerzonej rzeczywistości. Pisaliśmy już m.in. o IKEA Place.

Tim Cook w kilku wypowiedziach podkreślał, jak ważna dla Apple jest technologia AR, oraz że wiąże z jej rozwojem duże nadzieje.

ARKit + 3D skaner = doskonała rzeczywistość rozszerzona

ARKit i aplikacje z niego korzystające działają na iPhone na podstawie analizy obrazu i danych z sensorów ruchu i pozycji. Głębia i mapowanie 3D odbywa się jedynie za pomocą analizy danych z kamery. Radzi sobie z tym nawet iPhone 6s, jednak kosztem baterii, ponieważ wymaga to użycia pełnej mocy obliczeniowej. Nowe iPhone’y z A11 zostały wyposażone poza Neural engine, również w lepsze żyroskopy i akcelerometry. W tych samych scenach sprawdzają się lepiej niż np. iPhone 7 Plus. Jednak nadal z płaskiego obrazu z kamery nie daje się idealnie dokonać odwzorowania 3D. Pełne skanowanie ma to zmienić.

Jak podaje Bloomberg, tylny skaner 3D wykorzystujący technologię laserową ma się pojawić w iPhone’ach już w 2019 roku. Nie dość, że pozwoli robić idealne zdjęcia, to błyskawicznie stworzy model 3D (przynajmniej z widzianej strony) obiektów. Dodatkowo pozwoli na jeszcze bardziej precyzyjne śledzenie zmian położenia i kąta patrzenia na scenę oraz jej rozbudowę, wraz ze zmianą pozycji. Prawdopodobnie też będzie mniej energochłonny niż wysilona analiza obrazu. Dodajmy do tego następców Neural engine i mamy bazę do zastosowań, które obecnie nawet ciężko zdefiniować, bo część z nich dopiero zostanie wymyślona. Czeka nas kolejna rewolucja.

0 komentarzy